uniq 可检查文本文件中重复出现的行列。

语法

uniq [-cdu][-f<栏位>][-s<字符位置>][-w<字符位置>][--help][--version][输入文件][输出文件]

参数:

不附加任何选项时匹配行将在首次出现处被合并。

长选项必须使用的参数对于短选项时也是必需使用的。

需要配合sort 进行去重使用

-c, --count //在每行前加上表示相应行目出现次数的前缀编号

-d, --repeated //只输出重复的行

-D, --all-repeated //只输出重复的行,不过有几行输出几行

-f, --skip-fields=N //-f 忽略的段数,-f 1 忽略第一段

-i, --ignore-case //不区分大小写

-s, --skip-chars=N //根-f有点像,不过-s是忽略,后面多少个字符 -s 5就忽略后面5个字符

-u, --unique //去除重复的后,全部显示出来,根mysql的distinct功能上有点像

-z, --zero-terminated end lines with 0 byte, not newline

-w, --check-chars=N //对每行第N 个字符以后的内容不作对照

--help //显示此帮助信息并退出

--version //显示版本信息并退出

[输入文件] 指定已排序好的文本文件。如果不指定此项,则从标准读取数据;

[输出文件] 指定输出的文件。如果不指定此选项,则将内容显示到标准输出设备(显示终端)。

实例

文件testfile中第 2、3、5、6、7、9行为相同的行,使用 uniq 命令删除重复的行,可使用以下命令:

uniq testfile

testfile中的原有内容为:

$ cat testfile #原有内容

test 30

test 30

test 30

Hello 95

Hello 95

Hello 95

Hello 95

Linux 85

Linux 85

使用uniq 命令删除重复的行后,有如下输出结果:

$ uniq testfile #删除重复行后的内容

test 30

Hello 95

Linux 85

检查文件并删除文件中重复出现的行,并在行首显示该行重复出现的次数。使用如下命令:

uniq -c testfile

结果输出如下:

$ uniq -c testfile #删除重复行后的内容

3 test 30 #前面的数字的意义为该行共出现了3次

4 Hello 95 #前面的数字的意义为该行共出现了4次

2 Linux 85 #前面的数字的意义为该行共出现了2次 当重复的行并不相邻时,uniq 命令是不起作用的,即若文件内容为以下时,uniq 命令不起作用:

$ cat testfile1 # 原有内容

test 30

Hello 95

Linux 85

test 30

Hello 95

Linux 85

test 30

Hello 95

Linux 85

这时我们就可以使用 sort:

一般先排序 然后在去重

$ sort testfile1 | uniq

Hello 95

Linux 85

test 30

统计各行在文件中出现的次数:

$ sort testfile1 | uniq -c

3 Hello 95

3 Linux 85

3 test 30

在文件中找出重复的行:

$ sort testfile1 | uniq -d

Hello 95

Linux 85

test 30

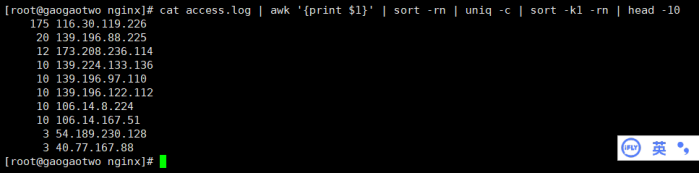

cat access.log | awk '{print $1}' | sort -rn | uniq -c | sort -k1 -rn | head -10

|